Вы хотите оптимизировать файл robots txt для WordPress? Или вы пока еще не знаете, насколько полезен и важен данный файл для SEO? Я помогу вам разобраться в этом вопросе.

В этой статье я не только расскажу, что такое настройка robots, но и покажу, как оптимизировать его для SEO, а также объясню, почему это так важно сделать.

В последнее время я все чаще получаю вопросы, связанные с файлом роботс – зачем он нужен и в чем его важность. Данный файл оказывает большое влияние на продвижение всего сайта; он как бы настраивает связь между вами и поисковыми системами, сообщая им какие именно части сайта они должны проиндексировать.

Содержание:

Содержание

Его отсутствие, конечно, не остановит поисковых ботов лазить и индексировать страницы вашего сайта. Тем не менее, я настоятельно рекомендую создать этот файл. Все дело в том, что файл robots помогает роботам узнать о существовании на вашем сайте файла XML sitemap, который является своеобразным путеводителем по сайту, указывающим ботам какие именно материалы нуждаются в первоочередной индексации. В противном случае вам придется прописывать ссылку на адрес карты сайта через Google Webmaster Tools. Впрочем, вы можете использовать два этих способа одновременно.

Но я все же настоятельно рекомендую создать на своем сайте правильный robots txt для WordPress.

Обычно он располагается в корневой папке сайта. Для его просмотра необходимо установить соединение с FTP-сервером (через Total Commander), либо воспользоваться файловым менеджером cPanel.

Он как и любой другой текстовый файл можно открыть в документе Блокнот.

Если в корневой папке вашего сайта нет этого файла, то вы всегда можете его создать. Для этого всего лишь нужно создать новый текстовый файл и сохранить его как robots.txt, а затем загрузить его в корневую папку сайта.

На самом деле формат файла robots.txt file предельно прост. Первая его строка – это, как правило, имя пользовательского агента. В качестве пользовательского агента выступает название поискового бота, который вы хотите привлечь на свой сайт. Например, это может быть Googlebot или Bingbot. Впрочем, вы можете здесь прописать «*», если хотите привлечь всех ботов.

Следующая строка должна содержать пометку «Allow» (разрешить) или «Disallow» (запретить), т.е. вы сообщаете поисковым системам, какие файлы, папки, разделы сайта и т.п. они должны индексироваться, а какие нет.

Вот пример:

|

1

2

3

4

|

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /readme.html

|

Из данного примера видно, что мы сообщаем всем поисковым ботам индексировать директорию, в которой хранятся все загруженные нами изображения сайта.

Следующие две строки файла запрещают поисковым ботам индексировать категорию плагинов WordPress и файл readme.html.

Руководство от Google для веб-мастеров советует не использовать файл robots.txt в случае если вы хотите скрыть от ботов контент низкого качества. Так что если вы собирались воспользоваться этим файлом для скрытия каких-либо категорий, данных и архивных страничек, то это далеко не самое мудрое решение.

Помните, цель robots.txt – это дать инструкции ботам, что делать с контентом, по которым они лазают, но никак не препятствовать их лазанью по вашему сайту.

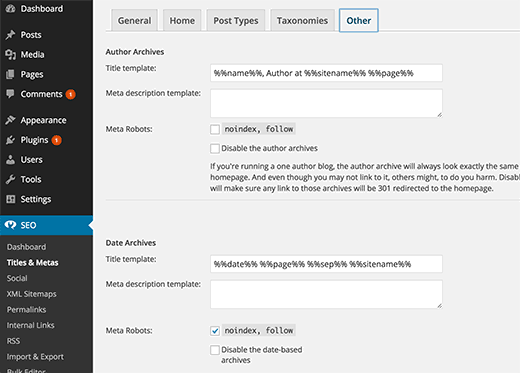

У Вордпресса есть плагины, которые позволяют добавлять мета-теги «nofollow» и «noindex» к архивным страничкам, а также для этих целей существует SEO плагин.

Я не то чтобы рекомендую этим заниматься, но если вы решили не индексировать архивные страницы, то вышеописанные способы являются лучшим решением.

Вам не нужно добавлять страницу админки WordPress, каталог администратора или регистрационный страницу в файл robots.txt, т.к. у этих страниц тег «noindex» помечен WP в качестве мета-тега.

Если вы используете вордпрессовский SEO плагин Yoast или какой-либо другой плагин для создания файла XML sitemap, то он постарается автоматически добавить в роботс строки, связанные с картой сайта.

Однако если у него по каким-либо причинам не получится это сделать, то он покажет вам ссылку на XML Sitemap, которую необходимо будет вручную добавить в файл robots. Выглядеть это будет примерно так:

|

1

2

|

Sitemap: http://www.example.com/post-sitemap.xml

Sitemap: http://www.example.com/page-sitemap.xml

|

Честно говоря, у многих популярных блогов он выглядит предельно просто. Конечно, содержание варьируется в зависимости от нужд конкретного сайта, но картинка примерно такая:

|

1

2

3

4

5

|

User-agent: *

Disallow:

Sitemap: http://www.example.com/post-sitemap.xml

Sitemap: http://www.example.com/page-sitemap.xml

|

Расшифровка этого файла следующая: всем поисковым ботом сообщается индексировать весь контент, и предоставляются ссылки на XML sitemaps сайта.

Вот еще один пример файла robots.txt, использующегося на сайте WPBeginner:

|

1

2

3

4

5

6

7

8

9

10

11

|

User-Agent: *

Allow: /?display=wide

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /readme.html

Disallow: /refer/

Sitemap: http://www.wpbeginner.com/post-sitemap.xml

Sitemap: http://www.wpbeginner.com/page-sitemap.xml

Sitemap: http://www.wpbeginner.com/deals-sitemap.xml

Sitemap: http://www.wpbeginner.com/hosting-sitemap.xml

|

А вот еще один правильный вариант файла на моем блоге. По крайней мере, ошибок не обнаружено, лишних мусорных страниц в индексе нет, все прекрасно живет в ТОП 10 🙂

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

User-agent: *

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /feed/

Disallow: */feed

Disallow: */trackback

Disallow: */comments

Disallow: /*?

Disallow: /*?*

Disallow: /tag

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /xmlrpc.php

Host: smarticle.ru

Sitemap: https://smarticle.ru/sitemap.xml

User-agent: Googlebot-Image

Allow: /wp-content/uploads/

User-agent: YandexImages

Allow: /wp-content/uploads/

Disallow: /CE20257AD2088B189632FDA110A16EB2.html

|

Вот и все. Надеюсь, что данная статья была вам полезна, и вы теперь знаете, что такое настройка robots и его оптимизация для SEO.

Если вам понравилась статья, то не забывайте ею делиться, ставить лайки, а также подписывайтесь на мой блог и канал в YouTube. Вы также можете найти меня вконтакте и заглядывайте в группу «Прибыльный e-mail маркетинг 2.0».

Я подготовил для Вас обращение, с ним можете ознакомиться тут

Макс Метелев - автор, блоггер, актер местного театра, ведущий городских мероприятий. Делюсь только лучшим!